У чому проблема?

Завдяки ШІ люди створюють милих "ШІ-котиків", малюють собі аватарки чи фантазують, якими будуть наші міста через сотні років. Але водночас цю технологію використовують і для обману та маніпуляцій.

Так, гортаючи стрічку Фейсбуку, ви можете натрапити на гарненьких "ссавцединозавриків". Вони зовсім не виглядають страшними чи кровожерливими, навпаки у них великі добрі очі та гарна усмішка. Вони розчулюють, отже кортить поставити лайк або навіть поширити пост на власній сторінці.

"Ссавцединозаврики". Фото з Фейсбуку Ігоря Розкладая

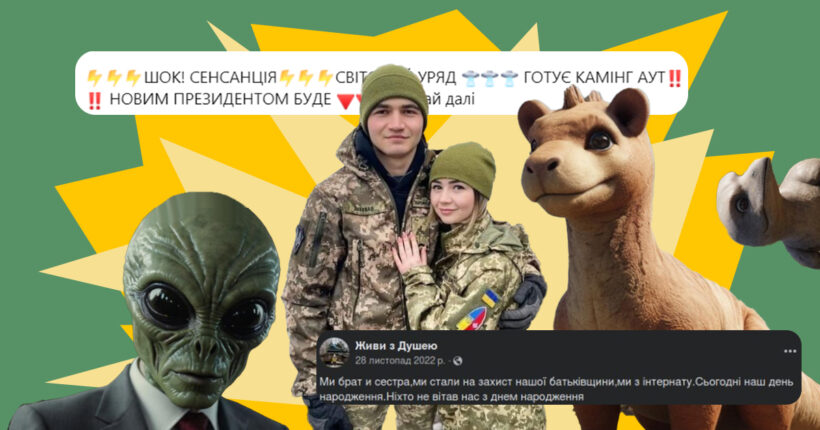

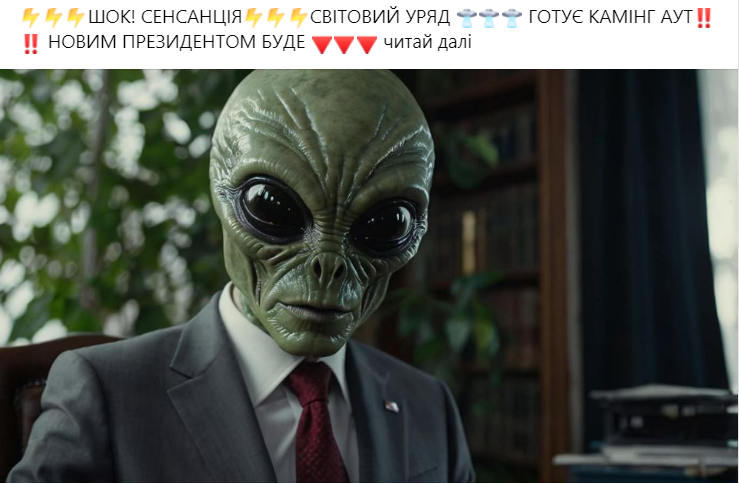

Але вже через декілька днів зміст цього безневинного допису змінюють. Тепер на фото чи то інопланетянин, чи то рептилоїд, який представляє таємний світовий уряд. На додачу з'являється загадковий підпис, який натякає на зміну влади. І під цим все ще стоїть ваша вподобайка.

Фото підміни змісту публікації (до та після заміни). Фото з Фейсбуку Ігоря Розкладая

Ця історія — експеримент, який на своїй сторінці провів експерт з модерації контенту в соціальних мережах ЦЕДЕМ Ігор Розкладай. Таким чином він хотів показати, як можна маніпулювати користувачами соцмереж завдяки фото, створеним штучним інтелектом. Проте таку маніпуляцію використовують і зловмисники.

"Отже, 100+ лайків за милого «ссавцединозаврика». І легким помахом руки я перетворюю цей пост у зрадофільство і конспірологію. Тож лайкаючи такі пости, ми можемо стати прекрасними бустерами (підсилювачами — ред.) поширення всякої маячні", — каже Ігор Розкладай про результати свого експерименту.

І це лише один зі способів, як за допомогою ШІ вами можуть скористатися. Ви можете допомогти шахраям чи поширити російську пропаганду, навіть не знаючи цього. А за словами Ігоря Розкладая, такого контенту стає дедалі більше у стрічці Фейсбуку, Інстаграму чи Тік-Току.

Яке рішення?

Щоб не лайкати і тим паче не поширювати згенеровані ШІ фейки чи маніпуляції, необхідно знати можливості цієї технології. Треба розуміти, що зараз можна підробити обличчя та голос будь-якої людини, тож навіть не кожне відео з військовим, політиком чи зіркою справжнє.

"В умовах постійного розвитку технологій єдиний спосіб вижити — це критичне мислення та знання, як працюють технології. Це не про знання кожної дрібниці. Але у людей має бути базове розуміння можливостей ШІ. Це має стати частиною нашої інформаційної гігієни", — говорить Ігор Розкладай.

Тож "Рубрика" разом з експертом розповідає, хто і де може використовувати контент, згенерований штучним інтелектом з поганими намірами. Далі також про те, як розпізнати ШІ у відео, аудіо та тексті.

Як це працює?

Згенерований ШІ контент доволі часто використовує російська пропаганда. За допомогою штучного інтелекту вони відтворюють обличчя та голос відомих людей. А далі поширюють фейкове відео, де такі копії озвучують наративи російської пропаганди. Цю технологію називають дипфейк.

Один з найвідоміших прикладів дипфейку — звернення буцімто Володимира Зеленського на початку повномасштабного вторгнення. У ньому нібито президент закликав українських військових скласти зброю, й оголосив, що сам планує виїхати з країни. Проте цей дипфейк був доволі неякісним і було очевидно, що це несправжнє відео.

"Щодо останньої дитячої провокації, що я нібито пропоную скласти зброю. Я можу пропонувати скласти зброю тільки військовим Російської Федерації — і повертатися додому. Ми вдома, ми захищаємо свою землю, своїх дітей, свої сім'ї. Тож ніяку зброю ми складати не збираємося до нашої перемоги", — так тоді відреагував президент на відеофейк.

Це відео було одним з перших, але точно не останніх дипфейків Зеленського. Згодом з'явилось ще декілька фейкових роликів. За допомогою ШІ росіяни не тільки поширювали фейкові заяви президента, але й намагались дискредитувати його.

Так, у мережі з'явилось відео, де нібито Зеленський виконує східний танок під російську музику у світлі диско-шару. Він сміється та бігає залом вбраний у жіночий одяг перед гостями, а наприкінці скидає із себе червону накидку та починає танцювати ще активніше.

Як розпізнати ШІ?

- Перше, на що варто звертати увагу — це зміст відео та його правдоподібність.

Якщо у відео відомі люди говорять чи роблять щось дивне та нелогічне, наприклад, заяви про капітуляцію чи танці президента, то це перша ознака фейковості контенту. Особливу увагу треба звертати, якщо такі нісенітниці відповідають наративам російської пропаганди.

- Якщо сумніви все ще залишаються, то варто звертати увагу на різні дефекти в аудіо та відео.

Наприклад, згенерований ШІ звук може мати неприродні частоти, хоча зазвичай це важко помітити без спеціальних програм. Проте можна звернути увагу на ліпсінк — відповідність руху губ до слів з аудіодоріжки.

Водночас набагато легше помітити помилки саме у відео чи фото. Для цього необхідно придивитись на контури обличчя, зокрема біля вух та щік. Ці місця будуть неприродно розмазані, особливо під час рухів головою. Розмиватись також можуть зморшки на обличчі. А ще різний тон шкіри може виказати штучний інтелект. Важливо звертати увагу на деталі.

Новини зі слідом ШІ

Але у дезінформаційних кампаніях штучний інтелект використовують не тільки заради дипфейків чи інших маніпуляцій з фото та відео. За допомогою ШІ можна також створювати сайти з фейковими новинами чи просувати різні наративи у соціальних мережах.

Так, у травні цього року компанія OpenAI, яка розробила ChatGPT, виявила п'ять онлайн-компаній, які використовували ШІ, щоб маніпулювати громадською думкою в усьому світі. Йшлося про компанії прихованого впливу, причетними до яких були державні структури та приватні компанії із Росії, Китаю, Ірану та Ізраїля.

Тоді штучний інтелект використовували, щоб створювати пости у соціальних мережах, перекладати та редагувати статті, писати заголовки. Метою було отримати підтримку політичних кампаній та вплинути на громадську думку щодо геополітичних конфліктів. Зокрема російська компанія Doppelganger користувалась ШІ, щоб писати антиукраїнські коментарі у соцмережі X.

"Насправді доволі важко розпізнати ШІ в тексті. Але найпростіше, що може видати штучний інтелект, — це помилки, фактологічні чи стилістичні. Хоча не кожен згенерований ШІ текст обов'язково матиме їх", — говорить Ігор Розкладай.

Ще один різновид шкідливих публікацій, згенерованих ШІ, — ті, що використовують, щоб накрутити лайки та зробити свою сторінку популярнішою. Часто це роблять завдяки емоційному контенту, який опосередковано впливає на вашу стрічку та вплітає до неї російську пропаганду.

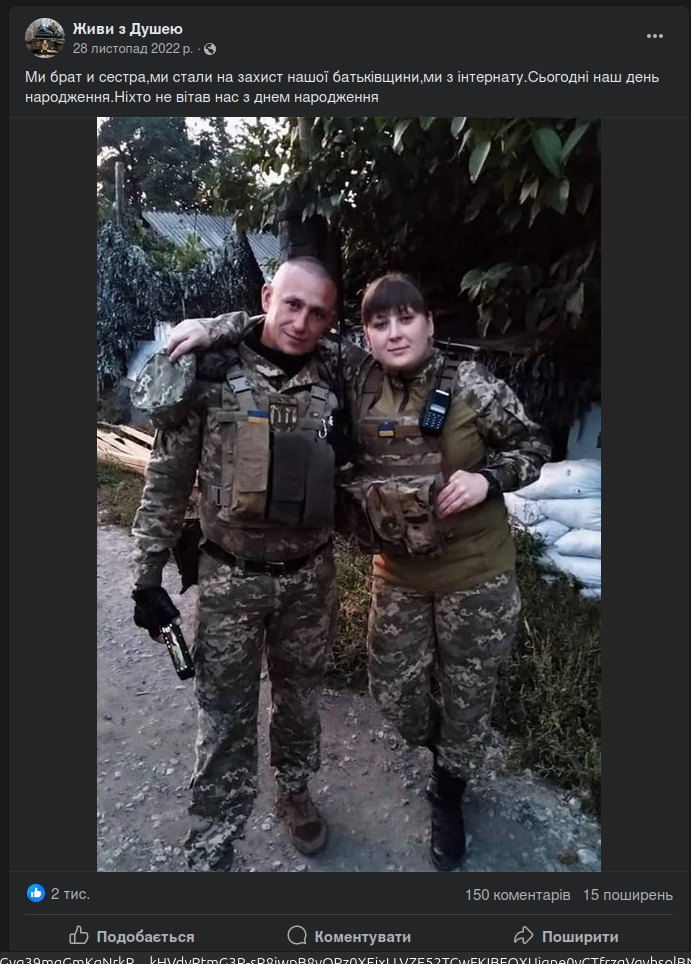

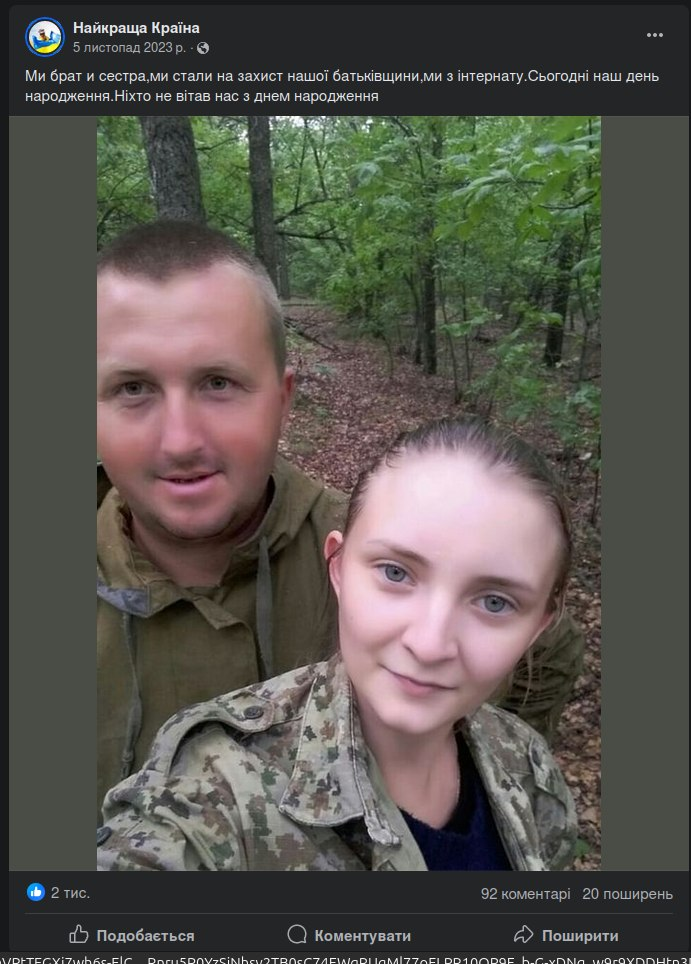

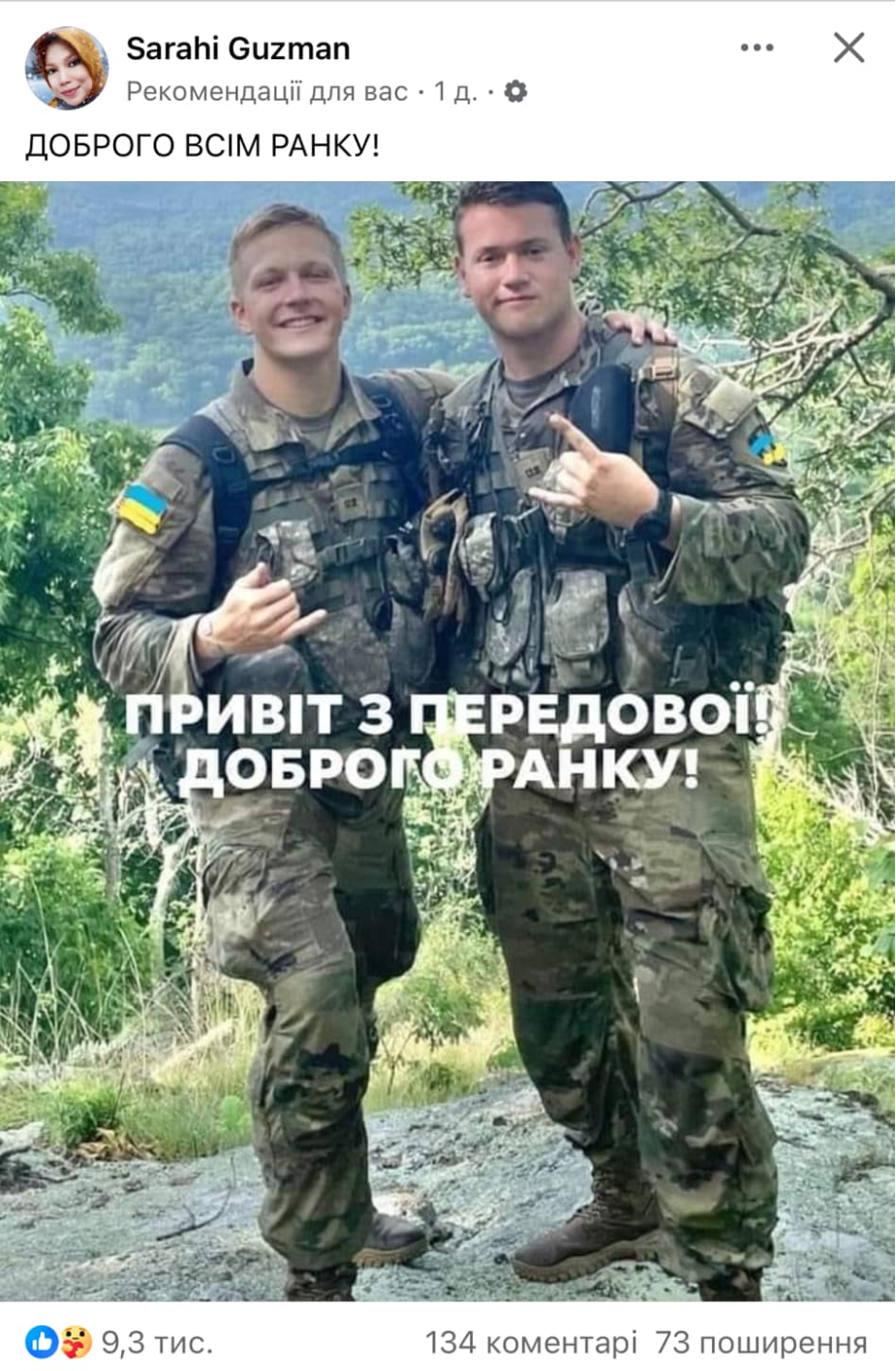

Немає жодної проблеми, якщо людина публікує картинку Пса Патрона, створену ШІ, щоб заробити більше вподобайок. Проте у соціальних мережах з'являється все більше публікації, де "брат і сестра з інтернату стали на захист нашої Батьківщини, але їх ніхто не привітав з днем народження".

Так, насправді ця "сумна" історія — фейк. Насправді обличчя цих військових створенні штучним інтелектом. Зроблені вони доволі якісно, тож такі фейки важко розпізнати. Чимало українців вірили у цю сумну історію та поширювали такі дописи, щоб якомога більше людей привітали українських військових.

Натомість вони лайкали та коментували публікації акаунтів, які, за словами Ігоря Розкладая, переважно зареєстровані у Вірменії та не мають нічого спільного з Силами оборони України. Навіщо вірменські акаунти це роблять? Точної відповіді немає, але часто після вподобайки під таким дописом у стрічці починають з'являтись публікації з ностальгією за радянським союзом, а далі йде "суцільна зрада".

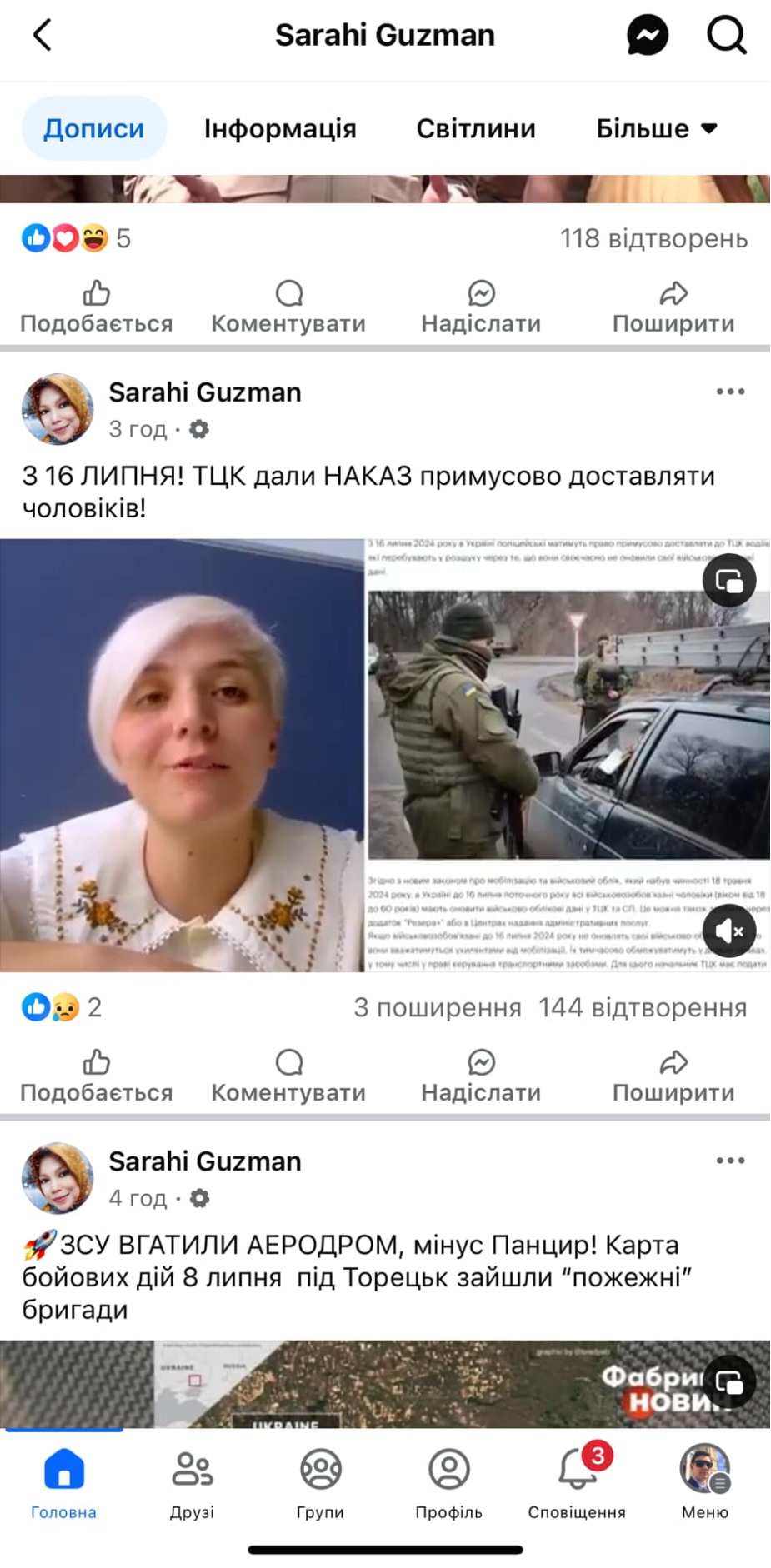

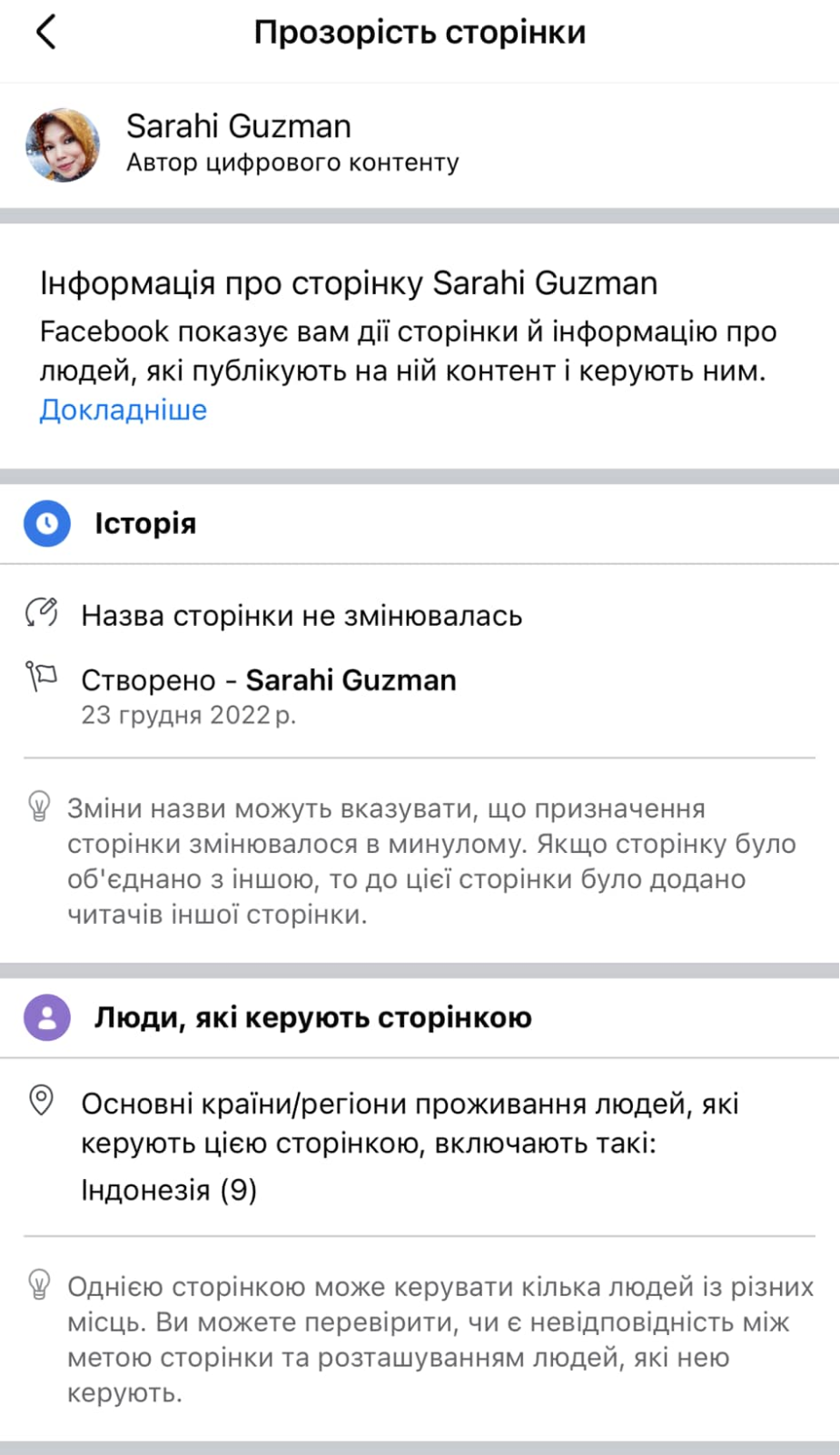

Схожі фейкові публікації можна побачити і від "сумних українських військових", зареєстрованих в Індонезії. Відмінність лише у тому, що міняється не зміст вашої стрічки, а самого акаунту. Початкові сумні емоційні дописи замінюються "зрадою" та, наприклад, посиланням на проросійські канали.

У мережі можна побачити й інші варіанти подібних маніпуляцій. Проте вони всі працюють однаково — спочатку вам пропонують чутливий та емоційний контент, нерідко пов'язаний з українськими військовими, а потім у стрічці з'являється проросійський контент від цього ж акаунту чи схожих. Саме тому, коли ви бачите емоційний контент, не поспішайте поширювати його, можливо вас хочуть обманути.

Також штучним інтелектом можуть користуватись шахраї. Наприклад, у Тік-Тоці поширювали нібито відеосюжети з українських телеканалів. У них ведучі говорили про новий закон №3386, відповідно до якого всі українці, що не виїжджали за кордон після 24 лютого 2022 року, могли отримати грошові виплати. Тоді завдяки ШІ імітували голоси українських телеведучих.

Як повідомили у Центрі протидії дезінформації при РНБО, це робили, щоб розрекламувати низку анонімних телеграм-каналів. Посилання на них було в описі до відео. Але схожі методи також можуть використовувати шахраї. Тоді замість посилання на канал може бути посилання на фейковий сайт, щоб викрасти особисті дані.

Проте обличчя українських телеведучих чи популярних особистостей можуть красти й інші. Так, завдяки штучному інтелекту можна зробити відео, де зірки рекламуватимуть біоактивні добавки, казино чи вступ до секти. І щось схоже вже з'являється в соціальних мережах. Тож варто пам'ятати: не все, що ви бачите обов'язково правда.

Тож коли ви гортаєте стрічку і бачите емоційне відео чи чергове звернення нібито Зеленського про капітуляцію, зупиніться та подумайте, чи це не фейковий контент, згенерований ШІ? Спочатку зверніть увагу на зміст, чи дійсно ця людина могла таке сказати? І взагалі, чи точно це справжня людина? Далі прислухайтесь до голосу, чи не здається він механічним? І наостанок придивіться до деталей: відповідність звуку та руху губ, неоднорідний тон шкіри, чіткість зображення, особливо біля щік та вух. Якщо все добре, можна вподобати цей допис.

Ми створили цей матеріал як учасник мережі "Вікно Відновлення". Все про відновлення постраждалих регіонів України дізнавайтеся на єдиній платформі recovery.win